AI领域发生了剧变。2025年1月,DeepSeek R1横空出世——一个开放权重的推理模型,在实现GPT-4级别性能的同时完全可以自托管。它在业界掀起巨浪,一度让英伟达市值蒸发近1万亿美元,迫使每个技术团队思考一个简单问题:我们为什么还要为云AI付费?

一年后,答案更加清晰。DeepSeek R1及其蒸馏版本通过Ollama在标准硬件上运行得非常出色。ChatGPT仍是一个精良的云产品——但需要持续付费,且数据要通过OpenAI的服务器。

在这个全面对比中,我们将分析成本、隐私、性能和使用场景,帮助你决定2026年哪条路适合你的团队。

TL;DR — 快速对比

| 特性 | DeepSeek R1(自托管) | ChatGPT(OpenAI云) |

|---|---|---|

| 托管方式 | 你的硬件/VPS | OpenAI服务器 |

| 成本模式 | 一次性硬件+电费 | 每用户20-200美元/月(订阅)或按Token付费API |

| 数据隐私 | 100%本地——数据不离开你的网络 | 数据在OpenAI服务器上处理 |

| 模型访问 | 开放权重(MIT许可证) | 专有,闭源 |

| 离线使用 | ✅ 完全离线功能 | ❌ 需要互联网 |

| 定制化 | 微调、量化、自由修改 | 仅限系统提示和GPTs |

| 推理质量 | 在数学和代码基准测试上与GPT-4o相当 | GPT-4o/o1最先进 |

| 安装难度 | Ollama约10分钟 | 注册即用 |

| 模型大小 | 15亿到6710亿参数 | N/A(仅云端) |

| 速率限制 | 无——仅受硬件限制 | 分级API速率限制 |

为什么DeepSeek R1改变了一切

开放权重革命

DeepSeek R1不只是另一个开源模型。它证明了一个中国AI实验室能够产生与OpenAI最好模型相媲美的推理能力——然后免费发布权重。模型家族从微小的15亿参数蒸馏版本(可在树莓派上运行)到完整的6710亿参数混合专家巨兽。

引人注目的关键基准结果:

- AIME 2024(数学):DeepSeek R1得分79.8%,与OpenAI的o1-mini相当

- Codeforces(竞赛编程):Elo评级2029——与顶级人类竞争者媲美

- MATH-500:97.3%准确率,超越GPT-4o

- GPQA Diamond(研究生级科学):71.5%,与o1-preview竞争

信息很明确:你不再需要每月200美元的API账单来获得前沿级推理能力。

为什么现在很重要

2026年,DeepSeek生态系统已显著成熟:

- Ollama为所有DeepSeek R1变体提供一键部署

- 量化模型(Q4_K_M、Q8)让70B蒸馏版本在64GB内存的MacBook Pro上流畅运行

- Open WebUI在你的本地模型上提供类ChatGPT界面

- 社区微调版本涵盖从法律到医学到代码审查的各个领域

基础设施已为生产做好准备。问题不是你能否自托管——而是为什么不呢?

成本对比:数字不会撒谎

2026年ChatGPT定价

OpenAI的定价结构已经演进,但核心模式依然:你按用户、按月、终身付费。

| 套餐 | 价格 | 你得到什么 |

|---|---|---|

| 免费 | 0美元 | 有限GPT-4o访问,速率限制 |

| Plus | 20美元/月 | 更多GPT-4o、o1访问、DALL-E、浏览 |

| Pro | 200美元/月 | 无限访问所有模型,o1 Pro模式 |

| Team | 25-30美元/用户/月 | 工作空间功能,管理控制 |

| Enterprise | 定制 | SSO、合规、专属支持 |

API定价(按Token付费):

- GPT-4o:约2.50美元/100万输入Token,约10美元/100万输出Token

- o1:约15美元/100万输入Token,约60美元/100万输出Token

对于使用ChatGPT Plus的10人开发团队,这是每年至少2400美元。大量API使用可轻松将成本推高到每年10000-50000美元。

自托管DeepSeek R1成本

自托管的美妙之处:成本固定且可预测。

| 配置 | 硬件成本 | 月度成本 | 性能级别 |

|---|---|---|---|

| MacBook Pro M4 Max(128GB) | 约4000美元(已有?) | 约5美元电费 | 舒适运行70B蒸馏版 |

| RTX 4090台式机(24GB) | 约2000美元GPU | 约10美元电费 | 高速运行32B蒸馏版 |

| VPS(Hetzner,8 vCPU,32GB) | —— | 约30美元/月 | 为小团队运行14B蒸馏版 |

| 双RTX 3090服务器 | 约3000美元总计 | 约20美元电费 | 运行70B蒸馏版,服务5-10用户 |

| 云GPU(RunPod/Vast.ai) | —— | 约50-150美元/月 | 可运行完整6710亿模型 |

10人团队盈亏平衡分析:

- 10用户ChatGPT Plus:200美元/月=2400美元/年

- Hetzner VPS自托管DeepSeek R1:30美元/月=360美元/年

- 节省:2040美元/年(85%)

这还是保守场景。如果你的团队大量使用API进行代码生成、文档分析或自动化工作流,节省会戏剧性地成倍增长。通过自托管,10000次查询与10次查询成本相同:零边际成本。

隐私:服务器机房里的大象

这是自托管提供最令人信服优势的地方——而且差距巨大。

ChatGPT的情况

当你向ChatGPT发送提示时:

- 你的数据通过互联网传输到OpenAI服务器(托管在Microsoft Azure上)

- 数据被处理,可能被记录,并根据OpenAI的数据保留政策存储

- OpenAI的隐私政策允许使用你的数据改进模型(除非通过API设置或企业计划选择退出)

- 无论你身在何处,你都受美国司法管辖

对于偶尔聊天的个人来说,这没问题。对于处理专有代码、法律文件、患者数据、财务记录或商业秘密的企业来说,这是不可接受的。

自托管DeepSeek R1的情况

你的数据永远不离开你的机器。句号。

- 提示在你的CPU/GPU上本地处理

- 无遥测,无外部服务器日志记录

- 默认完全符合GDPR/HIPAA——数据保留在你的司法管辖区

- 可进行气隙部署以获得最大安全性

- 你控制保留、加密和访问政策

对于受监管行业(医疗、金融、法律、政府),这不是锦上添花。这是要求。

真实隐私场景

| 场景 | ChatGPT | 自托管DeepSeek R1 |

|---|---|---|

| 审查专有源代码 | ⚠️ 代码发送到OpenAI服务器 | ✅ 保留在你的机器上 |

| 分析患者病历 | ❌ HIPAA合规风险 | ✅ 完全本地合规 |

| 总结机密法律简报 | ⚠️ 潜在数据暴露 | ✅ 可气隙运行 |

| 处理客户PII | ⚠️ 第三方数据处理器 | ✅ 你是唯一处理器 |

| 处理机密项目 | ❌ 不可能 | ✅ 离线能力 |

性能:它们实际如何对比?

让我们诚实对待每个选项能给你什么。

ChatGPT(GPT-4o/o1)的优势

- ✅多模态能力:图像理解、DALL-E生成、语音模式

- ✅浏览和插件:实时网页访问、代码执行

- ✅更大上下文窗口:GPT-4o最多128K token

- ✅尖端推理:o1和o1-pro处理复杂多步骤问题

- ✅零设置:从任何浏览器立即工作

DeepSeek R1的优势

- ✅无速率限制:生成硬件允许的尽可能多文本

- ✅一致延迟:无队列,无"我们正经历高需求"消息

- ✅定制化:在你的领域数据上微调以获得卓越专业性能

- ✅批处理:彻夜处理数千份文档无API成本

- ✅可重现性:相同模型、相同权重、确定性输出

基准对比(2025年发布结果)

| 基准测试 | DeepSeek R1(6710亿) | GPT-4o | o1-mini |

|---|---|---|---|

| MATH-500 | 97.3% | 74.6% | 90.0% |

| AIME 2024 | 79.8% | 9.3% | 63.6% |

| Codeforces Elo | 2029 | 759 | 1820 |

| GPQA Diamond | 71.5% | 49.9% | 60.0% |

| MMLU | 90.8% | 88.7% | 85.2% |

| SWE-bench Verified | 49.2% | 38.4% | 41.6% |

重要说明:这些是完整6710亿参数模型的基准。如果你在普通硬件上运行蒸馏的70亿或140亿变体,预期分数会更低。700亿蒸馏版保留了大部分推理能力,是自托管的最佳选择。

快速设置指南:DeepSeek R1 + Ollama + Open WebUI

这是如何在不到10分钟内从零到拥有自己的AI助手。

第1步:安装Ollama

# macOS / Linux

curl -fsSL https://ollama.com/install.sh | sh

# 或在macOS通过Homebrew

brew install ollama第2步:下载DeepSeek R1模型

根据你的硬件选择模型:

# 轻量级(最少4GB内存)——适合测试

ollama pull deepseek-r1:8b

# 中等(16GB内存)——可靠日常驱动

ollama pull deepseek-r1:14b

# 高级用户(32-64GB内存)——接近完整推理能力

ollama pull deepseek-r1:32b

# 野兽模式(64GB+内存或多GPU)——最高质量

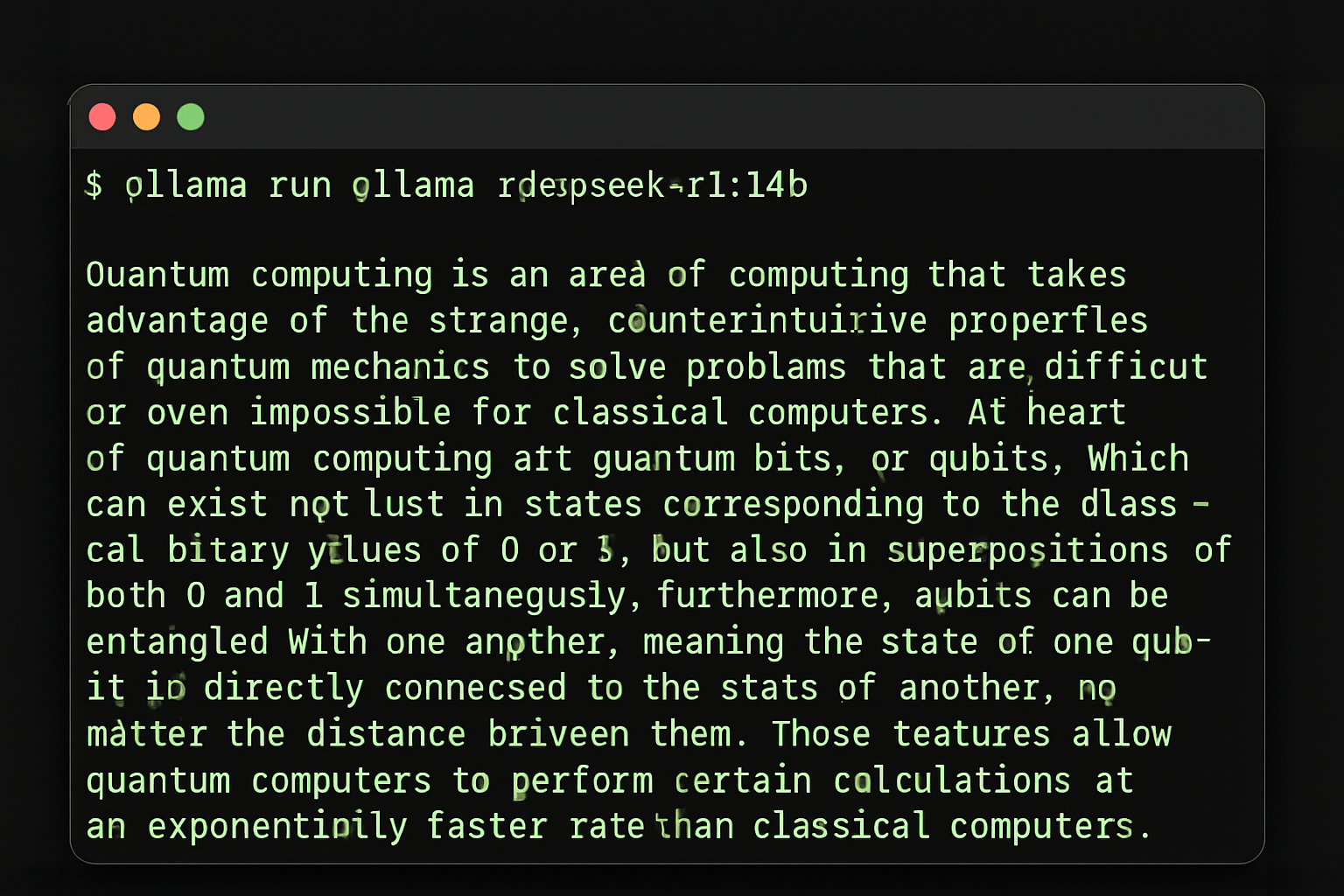

ollama pull deepseek-r1:70b第3步:在终端测试

ollama run deepseek-r1:14b

Ollama 运行 DeepSeek R1 — 一条命令即可开始

你可以立即开始聊天。输入你的问题并在本地获得回应!

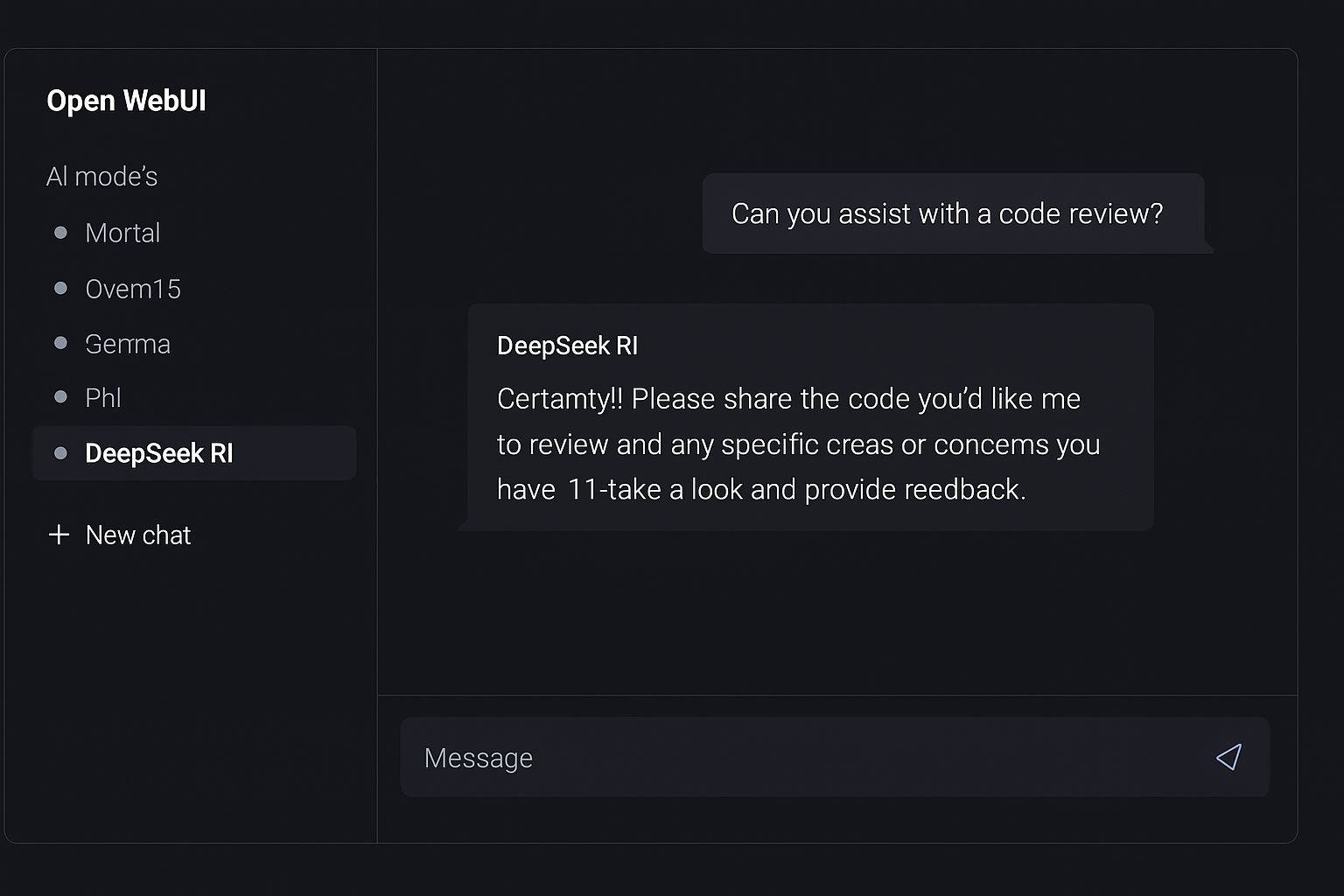

第4步:添加Open WebUI获得类ChatGPT界面

# 使用Docker(推荐)

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 \

--restart always \

ghcr.io/open-webui/open-webui:main

Open WebUI — 你本地AI的ChatGPT风格界面

现在在浏览器中打开http://localhost:3000。创建账户(这是本地的——第一个用户成为管理员),选择你的DeepSeek R1模型,开始聊天。

第5步:向你的团队开放(可选)

如果你想与同事分享,设置反向代理:

server {

listen 443 ssl;

server_name ai.yourcompany.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}你的团队现在拥有一个私人的自托管AI助手,配有精美的网页界面。总设置时间:约10分钟。

硬件要求按模型大小

为你的硬件选择合适的DeepSeek R1变体:

| 模型大小 | 内存需求 | GPU显存 | 性能级别 | 最适合 |

|---|---|---|---|---|

| 15亿 | 2GB | 可选 | 基础推理,快速响应 | IoT设备,测试 |

| 70亿 | 8GB | 6GB显存(可选) | 良好通用能力 | 个人使用,轻量工作负载 |

| 140亿 | 16GB | 12GB显存(可选) | 强推理,编程帮助 | 开发团队,日常使用 |

| 320亿 | 32GB | 24GB显存(推荐) | 优秀推理和编程 | 专业团队,复杂任务 |

| 700亿 | 64GB | 48GB+显存(推荐) | 接近完整模型能力 | 研究,企业使用 |

| 6710亿 | 500GB+ | 需要多GPU设置 | 最大能力 | 仅研究机构 |

VPS推荐:

- Hetzner CCX33(8 vCPU,32GB内存):完美运行140亿模型,约35欧元/月

- Hetzner CCX53(16 vCPU,64GB内存):良好运行320亿模型,约70欧元/月

- OVHcloud GPU实例:GPU加速推理,约80-150欧元/月

使用场景:何时选择什么

选择ChatGPT当:

- 🔵你需要多模态AI(图像分析、语音、DALL-E)

- 🔵你想要零维护和即时访问

- 🔵你是个人用户,使用适度(约20美元/月可以)

- 🔵你需要实时网页浏览集成在回应中

- 🔵你需要最新模型(OpenAI每周发布更新)

- 🔵你在构建原型想立即开始

选择自托管DeepSeek R1当:

- 🟢数据隐私不可妥协(受监管行业、专有代码)

- 🟢你有3+人团队(成本平摊,不按用户)

- 🟢你处理大量数据(批量分析、自动化管道)

- 🟢你需要离线能力(气隙环境、旅行)

- 🟢你想微调模型在你的领域数据上

- 🟢你在产品中集成AI(无API依赖)

- 🟢你想要可预测成本(无意外账单)

- 🟢你需要一致性能(无速率限制或停机)

混合方法

2026年许多团队运行两者:本地DeepSeek R1用于日常编程辅助、文档审查和批处理——同时保持ChatGPT Pro订阅用于偶尔的多模态任务和访问尖端模型。这给你两个世界的最佳效果,同时最小化云成本。

总体情况:为什么自托管AI很重要

向自托管AI的转变不只是为了省钱。这关乎主权。

当你依赖云AI提供商时,你受制于:

- 价格变化——OpenAI以前提过价,还会再提

- 政策变化——服务条款可能一夜之间改变

- 审查决定——模型会讨论什么,不会讨论什么

- 可用性——停机发生,速率限制收紧

- 地缘政治风险——访问可能按地区受限

- 模型更新——你喜欢的模型版本可能被停用

通过自托管模型,你拥有你的AI技术栈。你选择运行哪个模型、它如何表现、它看到什么数据、何时升级。这不只是技术优势——这是战略优势。

结论:2026年的明智之举

一年前,自托管AI是爱好者的实验。今天,它是生产就绪策略,被全球初创公司、企业和独立开发者使用。

DeepSeek R1提供与ChatGPT竞争的推理能力——在一些基准测试中甚至超越。Ollama使部署变得轻而易举。Open WebUI给你精美界面。你保持每一字节数据在你的控制之下。

计算很简单:

- 10人团队使用ChatGPT Plus:2400美元/年

- 10人团队使用自托管DeepSeek R1:360美元/年

- 年度节省:2040美元——加上完整数据主权

ChatGPT仍然是优秀产品。但当你能以一小部分成本匹配其核心能力,同时保持数据私密时,明智之举很清楚。

自托管革命不是即将到来——它已经在这里。问题是:你的团队将引领潮流,还是在边线观看?

准备探索更多自托管AI工具?浏览我们在hostly.sh上精心策划的自托管应用目录——从AI助手到自动化平台,我们帮你找到在自己基础设施上运行的最佳开源软件。

需要强大的VPS用于AI工作负载?查看我们专为机器学习和AI应用设计的优化托管方案。几分钟内在生产就绪服务器上开始使用DeepSeek R1。

觉得这个对比有帮助?查看我们关于流行SaaS工具自托管替代方案的其他指南。