Il panorama dell'IA è cambiato drasticamente. Nel gennaio 2025, DeepSeek R1 è esploso sulla scena — un modello di ragionamento open-weight che ha raggiunto prestazioni di classe GPT-4 pur essendo completamente self-hostabile. Ha mandato onde d'urto nell'industria, cancellando brevemente quasi 1 trilione di dollari dalla capitalizzazione di mercato di Nvidia e costringendo ogni team tech a porsi una semplice domanda: perché stiamo ancora pagando per l'IA cloud?

Un anno dopo, la risposta è ancora più chiara. DeepSeek R1 e le sue varianti distillate funzionano magnificamente su hardware commodity tramite Ollama. ChatGPT rimane un prodotto cloud raffinato — ma a costo ricorrente, con i tuoi dati che fluiscono attraverso i server di OpenAI.

In questo confronto completo, analizzeremo costo, privacy, prestazioni e casi d'uso per aiutarti a decidere quale percorso è giusto per il tuo team nel 2026.

TL;DR — Il confronto veloce

| Caratteristica | DeepSeek R1 (Self-Hosted) | ChatGPT (OpenAI Cloud) |

|---|---|---|

| Hosting | Il tuo hardware / VPS | Server OpenAI |

| Modello di costo | Hardware una tantum + elettricità | 20-200$/mese per utente (abbonamento) o API pay-per-token |

| Privacy dati | 100% locale — nulla lascia la tua rete | Dati processati sui server OpenAI |

| Accesso al modello | Pesi aperti (licenza MIT) | Proprietario, sorgente chiusa |

| Uso offline | ✅ Funzionalità completa offline | ❌ Richiede internet |

| Personalizzazione | Fine-tuning, quantizzazione, liberamente modificabile | Limitato a prompt di sistema e GPT |

| Qualità ragionamento | Paragonabile a GPT-4o sui benchmark math e codice | All'avanguardia con GPT-4o / o1 |

| Facilità setup | ~10 minuti con Ollama | Registrati e vai |

| Dimensioni modello | 1.5B a 671B parametri | N/A (solo cloud) |

| Limiti velocità | Nessuno — limitato solo dal tuo hardware | Limiti di velocità API stratificati |

Perché DeepSeek R1 ha cambiato tutto

DeepSeek R1 non era solo un altro modello open source. Era la prova che un laboratorio AI cinese poteva produrre capacità di ragionamento che rivaleggiavano con il meglio di OpenAI — e poi rilasciare i pesi gratuitamente. La famiglia di modelli va da una versione distillata di 1.5B (funziona su Raspberry Pi) al colosso completo di 671B parametri Mixture-of-Experts.

Risultati chiave dei benchmark che hanno attirato l'attenzione:

- AIME 2024 (Math): DeepSeek R1 ha ottenuto 79.8%, paragonabile all'o1-mini di OpenAI

- Codeforces (Programmazione competitiva): Rating Elo di 2.029 — rivaleggiando con i migliori competitor umani

- MATH-500: 97.3% di accuratezza, superando GPT-4o

- GPQA Diamond (Scienza livello laureato): 71.5%, competitivo con o1-preview

Il messaggio era inequivocabile: non hai più bisogno di una bolletta API da $200/mese per accedere al ragionamento di frontiera.

Perché è importante ora

Nel 2026, l'ecosistema DeepSeek è maturato significativamente:

- Ollama fornisce deployment con un comando per tutte le varianti DeepSeek R1

- Modelli quantizzati (Q4_K_M, Q8) permettono al distillato 70B di funzionare fluidamente su un MacBook Pro con 64GB RAM

- Open WebUI ti dà un'interfaccia simile a ChatGPT sul tuo modello locale

- Esistono fine-tune della community per ogni dominio dal legale al medico alla revisione del codice

Confronto costi: i numeri non mentono

Prezzi ChatGPT nel 2026

| Piano | Prezzo | Cosa ottieni |

|---|---|---|

| Gratuito | $0 | Accesso GPT-4o limitato, velocità limitata |

| Plus | $20/mese | Più GPT-4o, accesso o1, DALL-E, browsing |

| Pro | $200/mese | Accesso illimitato a tutti i modelli, modalità o1 Pro |

| Team | $25-30/utente/mese | Funzioni workspace, controlli admin |

| Enterprise | Personalizzato | SSO, compliance, supporto dedicato |

Per un team di 10 sviluppatori usando ChatGPT Plus, sono $2.400/anno minimo. L'uso intensivo delle API può facilmente spingere i costi a $10.000-50.000/anno.

Costi DeepSeek R1 self-hosted

La bellezza del self-hosting: i costi sono fissi e prevedibili.

| Setup | Costo hardware | Costo mensile | Livello prestazioni |

|---|---|---|---|

| MacBook Pro M4 Max (128GB) | ~$4.000 (già lo hai?) | ~$5 elettricità | Esegue il distillato 70B comodamente |

| Desktop con RTX 4090 (24GB) | ~$2.000 GPU | ~$10 elettricità | Esegue il distillato 32B ad alta velocità |

| VPS (Hetzner, 8 vCPU, 32GB) | — | ~$30/mese | Esegue il distillato 14B per piccolo team |

| Server dual RTX 3090 | ~$3.000 totale | ~$20 elettricità | Esegue il distillato 70B, serve 5-10 utenti |

Analisi del pareggio per un team di 10 persone:

- ChatGPT Plus per 10 utenti: $200/mese = $2.400/anno

- DeepSeek R1 self-hosted su VPS Hetzner: $30/mese = $360/anno

- Risparmio: $2.040/anno (85%)

Privacy: l'elefante nella server room

Cosa succede con ChatGPT

Quando invii un prompt a ChatGPT:

- I tuoi dati viaggiano su internet verso i server di OpenAI (ospitati su Microsoft Azure)

- Vengono processati, potenzialmente loggati e archiviati secondo le politiche di ritenzione dati di OpenAI

- La privacy policy di OpenAI permette l'uso dei tuoi dati per il miglioramento del modello (a meno che non fai opt-out via impostazioni API o piano Enterprise)

- Sei soggetto alla giurisdizione USA, indipendentemente da dove ti trovi

Per individui che chattano casualmente, va bene. Per aziende che gestiscono codice proprietario, documenti legali, dati pazienti, record finanziari o segreti commerciali, è inaccettabile.

Cosa succede con DeepSeek R1 self-hosted

I tuoi dati non lasciano mai la tua macchina. Punto.

- I prompt vengono processati localmente sulla tua CPU/GPU

- Nessuna telemetria, nessun logging verso server esterni

- Compliance GDPR/HIPAA completa di default — i dati rimangono nella tua giurisdizione

- Deployment air-gapped possibile per massima sicurezza

- Controlli ritenzione, crittografia e politiche di accesso

Performance: come si confrontano realmente?

Dove ChatGPT (GPT-4o / o1) vince

- ✅Capacità multimodali: comprensione immagini, generazione DALL-E, modalità vocale

- ✅Browsing e plugin: accesso web real-time, esecuzione codice

- ✅Finestre di contesto più ampie: fino a 128K token con GPT-4o

- ✅Ragionamento all'avanguardia: o1 e o1-pro per problemi complessi multi-step

- ✅Setup zero: funziona istantaneamente da qualsiasi browser

Dove DeepSeek R1 vince

- ✅Nessun limite di velocità: genera tanto testo quanto il tuo hardware permette

- ✅Latenza consistente: nessuna coda, nessun messaggio "stiamo sperimentando alta domanda"

- ✅Personalizzazione: fine-tuning sui tuoi dati di dominio per prestazioni specializzate superiori

- ✅Elaborazione batch: processa migliaia di documenti durante la notte senza costi API

- ✅Riproducibilità: stesso modello, stessi pesi, output deterministici

Guida setup rapido: DeepSeek R1 + Ollama + Open WebUI

Passo 1: Installa Ollama

# macOS / Linux

curl -fsSL https://ollama.com/install.sh | sh

# O su macOS via Homebrew

brew install ollamaPasso 2: Scarica un modello DeepSeek R1

# Leggero (4GB RAM minimo) — buono per test

ollama pull deepseek-r1:8b

# Medio (16GB RAM) — driver quotidiano solido

ollama pull deepseek-r1:14b

# Utente esperto (32-64GB RAM) — capacità di ragionamento quasi completa

ollama pull deepseek-r1:32b

# Modalità bestia (64GB+ RAM o multi-GPU) — qualità massima

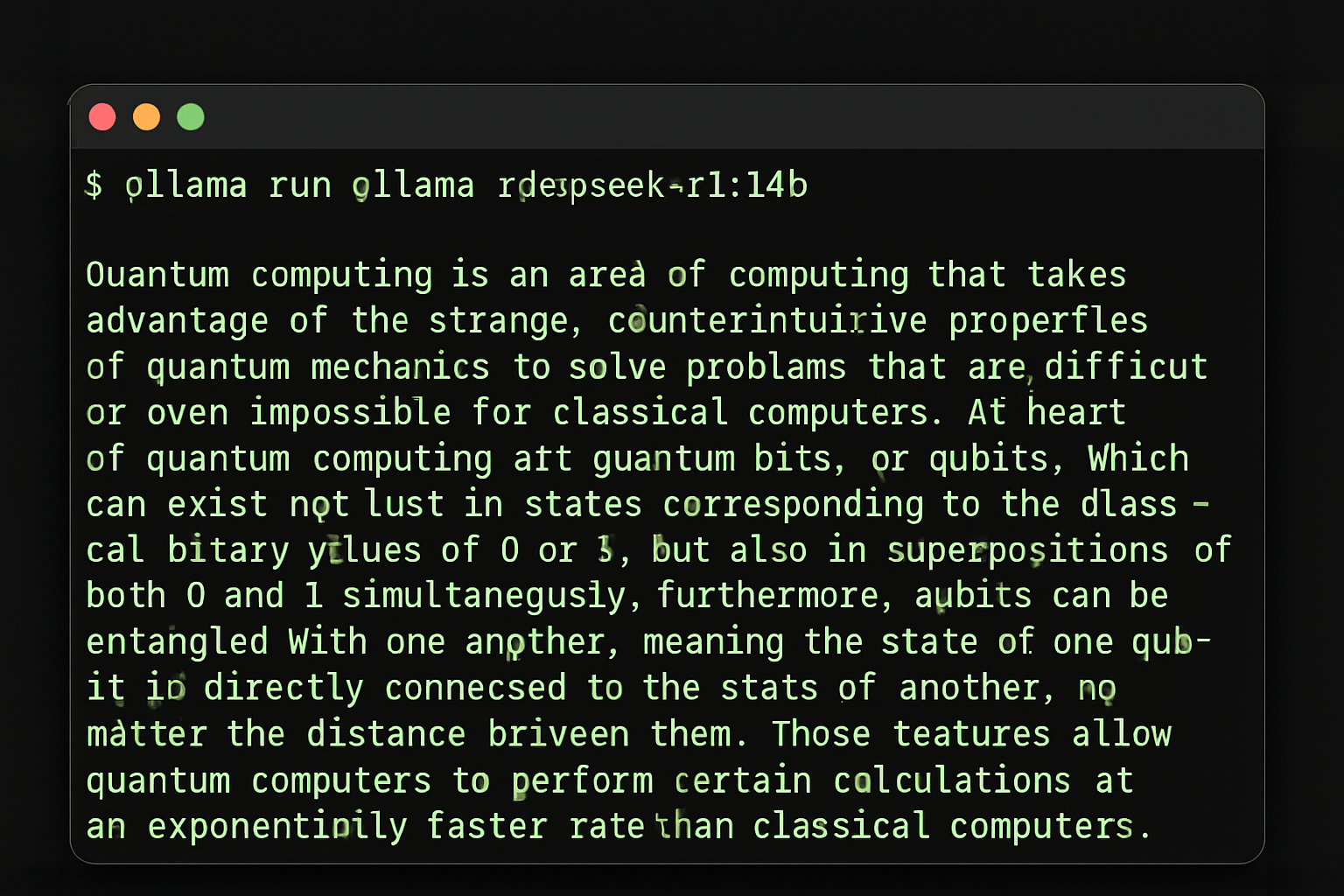

ollama pull deepseek-r1:70bPasso 3: Testa nel terminale

ollama run deepseek-r1:14b

Ollama con DeepSeek R1 — un solo comando per iniziare

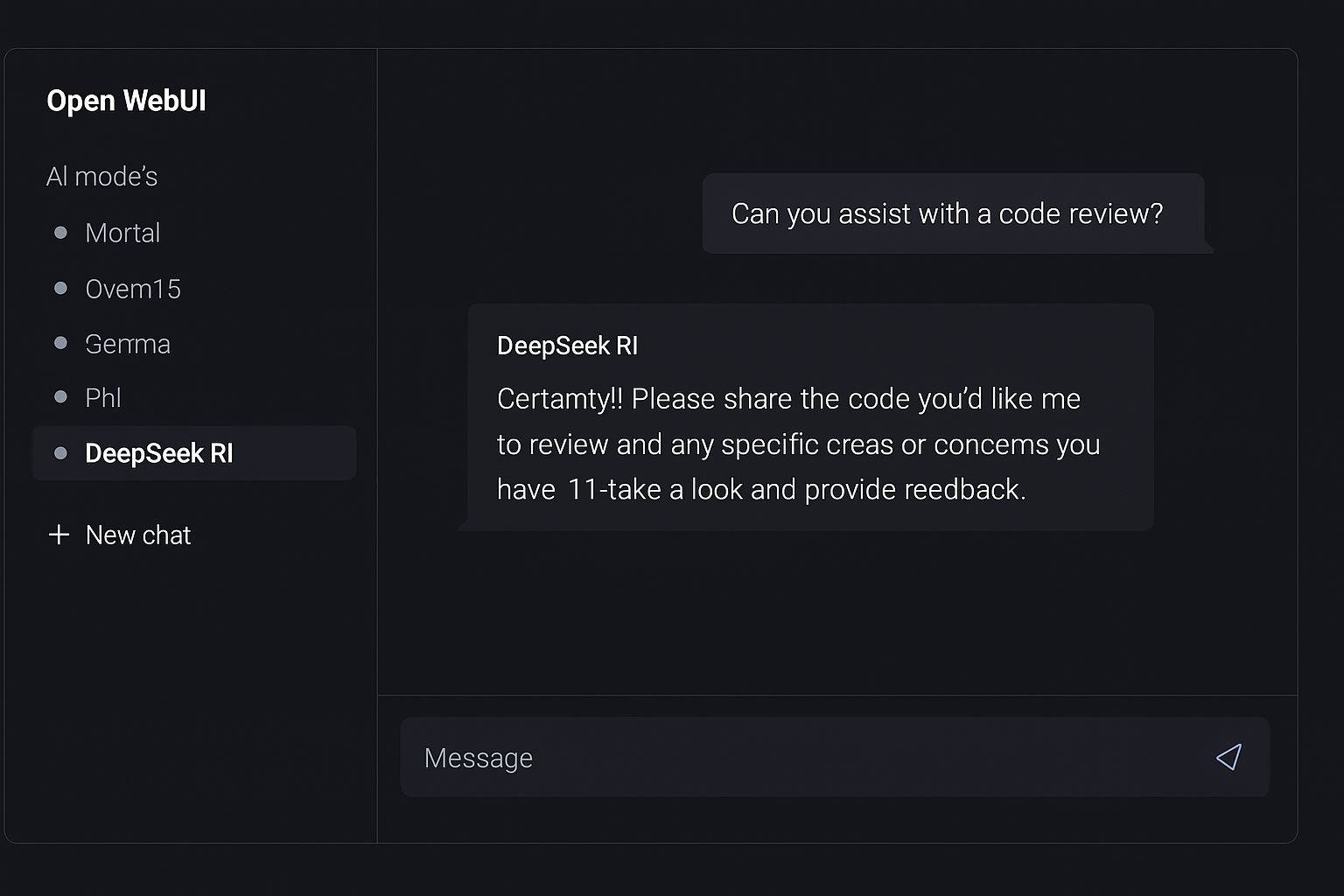

Passo 4: Aggiungi Open WebUI per interfaccia simile a ChatGPT

# Usando Docker (raccomandato)

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 \

--restart always \

ghcr.io/open-webui/open-webui:main

Open WebUI — un'interfaccia tipo ChatGPT per la tua IA locale

Ora apri http://localhost:3000 nel tuo browser. Crea un account (è locale — il primo utente diventa admin), seleziona il tuo modello DeepSeek R1 e inizia a chattare.

Casi d'uso: quando scegliere cosa

Scegli ChatGPT quando:

- 🔵Hai bisogno di IA multimodale (analisi immagini, voce, DALL-E)

- 🔵Vuoi manutenzione zero e accesso istantaneo

- 🔵Sei un utente singolo con uso moderato (~$20/mese va bene)

- 🔵Hai bisogno di browsing web real-time integrato nelle risposte

- 🔵Hai bisogno del modello più recente (OpenAI rilascia aggiornamenti settimanali)

Scegli DeepSeek R1 self-hosted quando:

- 🟢La privacy dei dati non è negoziabile (industrie regolamentate, codice proprietario)

- 🟢Hai un team di 3+ (i costi si distribuiscono, non per utente)

- 🟢Processi volumi alti (analisi batch, pipeline automatizzate)

- 🟢Hai bisogno di capacità offline (ambienti air-gapped, viaggi)

- 🟢Vuoi fare fine-tuning del modello sui tuoi dati di dominio

- 🟢Stai costruendo IA nel tuo prodotto (nessuna dipendenza API)

- 🟢Vuoi costi prevedibili (nessuna bolletta a sorpresa)

Conclusione: la mossa intelligente nel 2026

Un anno fa, il self-hosting dell'IA era un esperimento per hobbisti. Oggi, è una strategia pronta per la produzione utilizzata da startup, aziende e sviluppatori indipendenti in tutto il mondo.

DeepSeek R1 offre capacità di ragionamento che competono con — e in alcuni benchmark superano — ChatGPT. Ollama rende il deployment banale. Open WebUI ti dà un'interfaccia raffinata. E mantieni ogni byte di dati sotto il tuo controllo.

La matematica è semplice:

- Team di 10 persone su ChatGPT Plus: $2.400/anno

- Team di 10 persone su DeepSeek R1 self-hosted: $360/anno

- Risparmio annuale: $2.040 — più sovranità completa dei dati

ChatGPT rimane un prodotto eccellente. Ma quando puoi eguagliare le sue capacità principali a una frazione del costo mantenendo i tuoi dati privati, la mossa intelligente è chiara.

Pronto a esplorare più strumenti IA self-hosted? Sfoglia il nostro directory curato di applicazioni self-hostable su hostly.sh — dagli assistenti IA alle piattaforme di automazione, ti aiutiamo a trovare il miglior software open source da eseguire sulla tua infrastruttura.

Hai trovato utile questo confronto? Dai un'occhiata alle nostre altre guide su alternative self-hosted a strumenti SaaS popolari.