AIの世界は劇的に変化しました。2025年1月、DeepSeek R1が登場 — 完全にセルフホスト可能でありながらGPT-4クラスの性能を実現するオープンウェイトの推論モデルです。業界に衝撃を与え、一時的にNvidiaの時価総額から約1兆ドルを消去し、すべての技術チームにシンプルな質問を投げかけました:なぜまだクラウドAIにお金を払っているのか?

一年後、答えはより明確になりました。DeepSeek R1とその蒸留バリアントは、Ollamaを通じて一般的なハードウェアで美しく動作します。ChatGPTは洗練されたクラウド製品のまま — しかし継続的なコストで、あなたのデータはOpenAIのサーバーを経由します。

この包括的な比較では、コスト、プライバシー、パフォーマンス、ユースケースを分析し、2026年にどちらの道があなたのチームに適しているかを決定するお手伝いをします。

TL;DR — クイック比較

| 機能 | DeepSeek R1(セルフホスト) | ChatGPT(OpenAIクラウド) |

|---|---|---|

| ホスティング | あなたのハードウェア/VPS | OpenAIサーバー |

| コストモデル | 一回限りのハードウェア + 電気代 | ユーザーあたり月額20-200ドル(サブスクリプション)またはトークン課金API |

| データプライバシー | 100%ローカル — データはネットワークを離れない | データはOpenAIサーバーで処理 |

| モデルアクセス | オープンウェイト(MITライセンス) | プロプライエタリ、クローズドソース |

| オフライン使用 | ✅ 完全なオフライン機能 | ❌ インターネットが必要 |

| カスタマイズ | ファインチューニング、量子化、自由に変更可能 | システムプロンプトとGPTに限定 |

| 推論品質 | 数学とコードのベンチマークでGPT-4oに匹敵 | GPT-4o/o1で最先端 |

| セットアップの簡単さ | Ollamaで約10分 | サインアップして開始 |

| モデルサイズ | 15億から6710億パラメータ | N/A(クラウドのみ) |

| レート制限 | なし — ハードウェアによってのみ制限 | 階層化されたAPIレート制限 |

なぜDeepSeek R1がすべてを変えたのか

オープンウェイト革命

DeepSeek R1は単なるもう一つのオープンソースモデルではありませんでした。中国のAIラボがOpenAIの最高級モデルに匹敵する推論能力を生み出し、ウェイトを無料で公開できることの証明でした。モデルファミリーは小さな15億パラメータ蒸留版(Raspberry Piで実行可能)から、フル6710億パラメータのMixture-of-Expertsの巨獣まで範囲に及びます。

注目を集めた主要ベンチマーク結果:

- AIME 2024(数学):DeepSeek R1は79.8%のスコアを記録、OpenAIのo1-miniに匹敵

- Codeforces(競技プログラミング):Eloレーティング2,029 — 人間のトップ競技者に匹敵

- MATH-500:97.3%の精度、GPT-4oを上回る

- GPQA Diamond(大学院レベルの科学):71.5%、o1-previewと競争力あり

メッセージは明確でした:フロンティアレベルの推論にアクセスするために月額200ドルのAPI料金はもう必要ありません。

なぜ今重要なのか

2026年、DeepSeekエコシステムは大幅に成熟しました:

- OllamaはすべてのDeepSeek R1バリアント用のワンコマンドデプロイを提供

- 量子化モデル(Q4_K_M、Q8)により、70Bディスティレートが64GB RAMのMacBook Proでスムーズに実行

- Open WebUIがローカルモデルの上にChatGPTライクなインターフェースを提供

- 法律から医療、コードレビューまで、あらゆるドメインのコミュニティファインチューンが存在

インフラストラクチャは本番環境に対応しています。問題はセルフホストができるかではなく、なぜしないのかです。

コスト比較:数字は嘘をつかない

2026年のChatGPT価格

OpenAIの価格構造は進化しましたが、核心モデルは変わりません:ユーザーごと、月ごと、永続的に支払います。

| プラン | 価格 | 提供内容 |

|---|---|---|

| 無料 | 0ドル | 限定GPT-4oアクセス、レート制限あり |

| Plus | 月額20ドル | より多くのGPT-4o、o1アクセス、DALL-E、ブラウジング |

| Pro | 月額200ドル | すべてのモデルへの無制限アクセス、o1 Proモード |

| Team | ユーザーあたり月額25-30ドル | ワークスペース機能、管理コントロール |

| Enterprise | カスタム | SSO、コンプライアンス、専用サポート |

API価格(トークン課金):

- GPT-4o:入力トークン100万あたり約2.50ドル、出力トークン100万あたり約10ドル

- o1:入力トークン100万あたり約15ドル、出力トークン100万あたり約60ドル

ChatGPT Plusを使用する10人の開発チームの場合、年間最低2,400ドルです。APIの集約的な使用は容易にコストを年間10,000-50,000ドルに押し上げる可能性があります。

セルフホストDeepSeek R1のコスト

セルフホスティングの美しさ:コストは固定で予測可能です。

| セットアップ | ハードウェアコスト | 月額コスト | パフォーマンス層 |

|---|---|---|---|

| MacBook Pro M4 Max(128GB) | 約4,000ドル(既に持っている?) | 電気代約5ドル | 70Bディスティレートを快適に実行 |

| RTX 4090デスクトップ(24GB) | GPU約2,000ドル | 電気代約10ドル | 32Bディスティレートを高速実行 |

| VPS(Hetzner、8 vCPU、32GB) | — | 月額約30ドル | 小チーム向け14Bディスティレート実行 |

| デュアルRTX 3090サーバー | 総額約3,000ドル | 電気代約20ドル | 70Bディスティレート実行、5-10ユーザーに提供 |

| クラウドGPU(RunPod/Vast.ai) | — | 月額約50-150ドル | フル6710億モデルが可能 |

10人チームの損益分岐点分析:

- 10ユーザーのChatGPT Plus:月額200ドル = 年額2,400ドル

- Hetzner VPSでのセルフホストDeepSeek R1:月額30ドル = 年額360ドル

- 節約:年額2,040ドル(85%)

そしてこれは保守的なシナリオです。あなたのチームがコード生成、文書分析、自動化ワークフロー用にAPIを集約的に使用する場合、節約は劇的に倍増します。セルフホスティングでは、10,000クエリのコストは10クエリと同じです:ゼロ限界コストです。

プライバシー:サーバールームの象

ここで、セルフホスティングは最も説得力のある利点を提供します — そしてそれは比較になりません。

ChatGPTで何が起こるか

ChatGPTにプロンプトを送信すると:

- あなたのデータはインターネットを経由してOpenAIのサーバー(Microsoft Azure上でホスト)に移動

- 処理され、ログに記録される可能性があり、OpenAIのデータ保持ポリシーに従って保存

- OpenAIのプライバシーポリシーでは、モデル改善のためのデータ使用を許可(API設定またはEnterpriseプランでオプトアウトしない限り)

- あなたがどこにいようと、米国の司法権に服することになる

時々チャットする個人にとっては問題ありません。プロプライエタリコード、法的文書、患者データ、財務記録、企業秘密を扱う企業にとっては受け入れられません。

セルフホストDeepSeek R1で何が起こるか

あなたのデータはマシンを離れることはありません。以上です。

- プロンプトはあなたのCPU/GPUでローカルに処理される

- テレメトリなし、外部サーバーへのログ記録なし

- デフォルトで完全なGDPR/HIPAA準拠 — データはあなたの司法権にとどまる

- 最大セキュリティのためのエアギャップ展開が可能

- 保持、暗号化、アクセスポリシーをあなたがコントロール

規制業界(医療、金融、法律、政府)にとって、これはあったら良いものではありません。要件です。

現実のプライバシーシナリオ

| シナリオ | ChatGPT | セルフホストDeepSeek R1 |

|---|---|---|

| プロプライエタリソースコードのレビュー | ⚠️ コードがOpenAIサーバーに送信 | ✅ あなたのマシンにとどまる |

| 患者医療記録の分析 | ❌ HIPAA準拠リスク | ✅ 完全にローカル準拠 |

| 機密法的摘要の要約 | ⚠️ データ露出の可能性 | ✅ エアギャップ可能 |

| 顧客PIIの処理 | ⚠️ サードパーティデータプロセッサー | ✅ あなたが唯一のプロセッサー |

| 機密プロジェクトでの作業 | ❌ 不可能 | ✅ オフライン対応 |

パフォーマンス:実際にはどう比較されるか?

各オプションで何が得られるかについて正直になりましょう。

ChatGPT(GPT-4o / o1)が勝つところ

- ✅マルチモーダル機能:画像理解、DALL-E生成、音声モード

- ✅ブラウジングとプラグイン:リアルタイムウェブアクセス、コード実行

- ✅より大きなコンテキストウィンドウ:GPT-4oで最大128Kトークン

- ✅最先端の推論:複雑なマルチステップ問題にo1とo1-pro

- ✅ゼロセットアップ:任意のブラウザから即座に動作

DeepSeek R1が勝つところ

- ✅レート制限なし:ハードウェアが許可する限りテキスト生成

- ✅一貫したレイテンシ:キューなし、「高需要を経験しています」メッセージなし

- ✅カスタマイズ:あなたのドメインデータでのファインチューニングで優れた専門パフォーマンス

- ✅バッチ処理:APIコストなしで一晩に数千のドキュメントを処理

- ✅再現性:同じモデル、同じウェイト、決定論的出力

ベンチマーク比較(2025年公開結果)

| ベンチマーク | DeepSeek R1(6710億) | GPT-4o | o1-mini |

|---|---|---|---|

| MATH-500 | 97.3% | 74.6% | 90.0% |

| AIME 2024 | 79.8% | 9.3% | 63.6% |

| Codeforces Elo | 2,029 | 759 | 1,820 |

| GPQA Diamond | 71.5% | 49.9% | 60.0% |

| MMLU | 90.8% | 88.7% | 85.2% |

| SWE-bench Verified | 49.2% | 38.4% | 41.6% |

重要な注意事項:これらはフル6710億モデルのベンチマークです。控えめなハードウェアで蒸留70億または140億バリアントを実行している場合、より低いスコアを期待してください。700億ディスティレートは推論能力の大部分を保持し、セルフホスティングの最適点です。

クイックセットアップガイド:DeepSeek R1 + Ollama + Open WebUI

10分未満でゼロから自分のAIアシスタントまでの方法は次のとおりです。

ステップ1:Ollamaをインストール

# macOS / Linux

curl -fsSL https://ollama.com/install.sh | sh

# またはmacOSでHomebrew経由

brew install ollamaステップ2:DeepSeek R1モデルをダウンロード

ハードウェアに基づいてモデルを選択:

# 軽量(最小4GB RAM) — テストに適している

ollama pull deepseek-r1:8b

# 中級(16GB RAM) — 堅実な日常ドライバー

ollama pull deepseek-r1:14b

# パワーユーザー(32-64GB RAM) — ほぼ完全な推論能力

ollama pull deepseek-r1:32b

# ビーストモード(64GB+ RAMまたはマルチGPU) — 最高品質

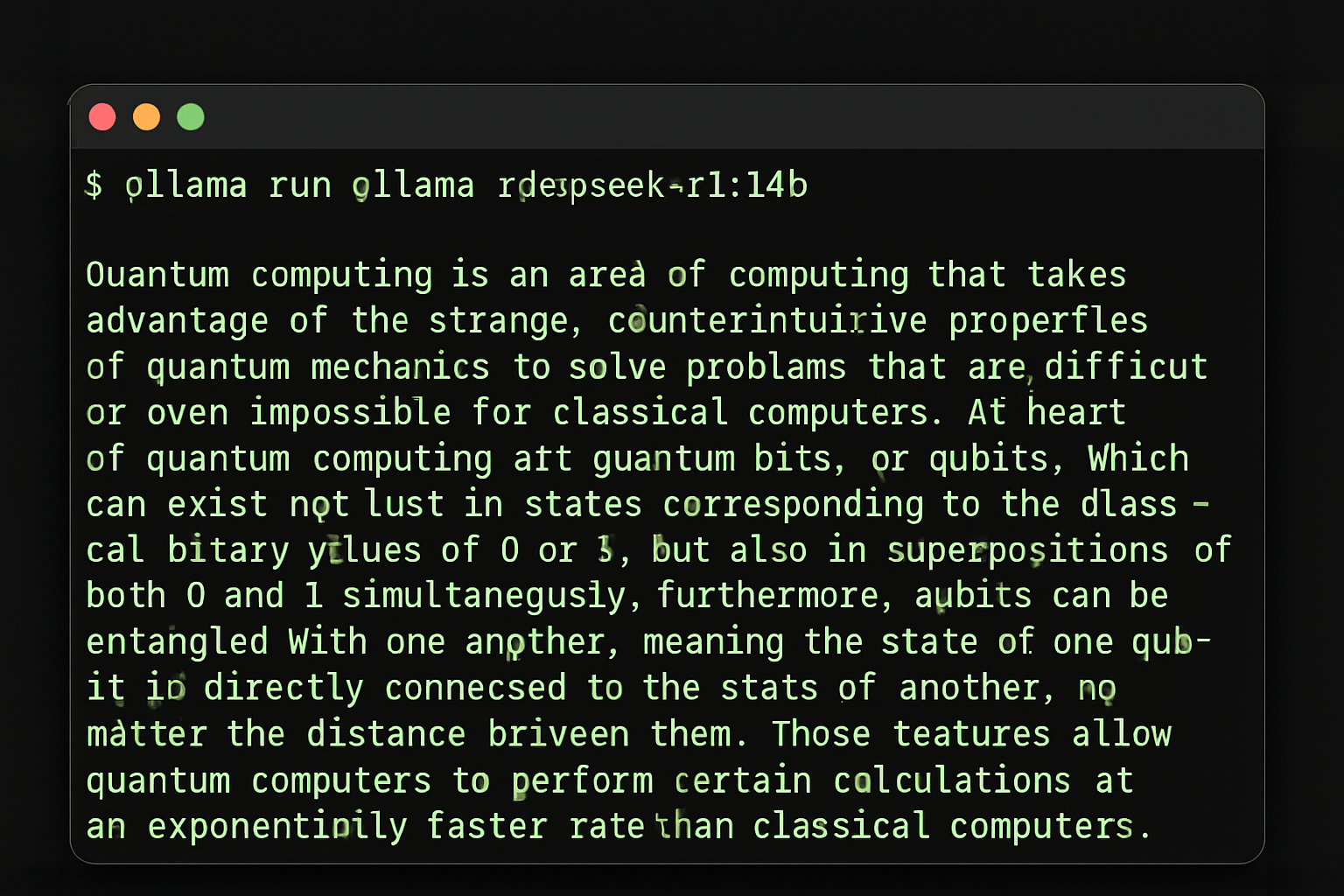

ollama pull deepseek-r1:70bステップ3:ターミナルでテスト

ollama run deepseek-r1:14b

OllamaでDeepSeek R1を実行 — ワンコマンドで開始

すぐにチャットを始めることができます。質問を入力してローカルで回答を得てください!

ステップ4:ChatGPTライクなインターフェース用にOpen WebUIを追加

# Dockerを使用(推奨)

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 \

--restart always \

ghcr.io/open-webui/open-webui:main

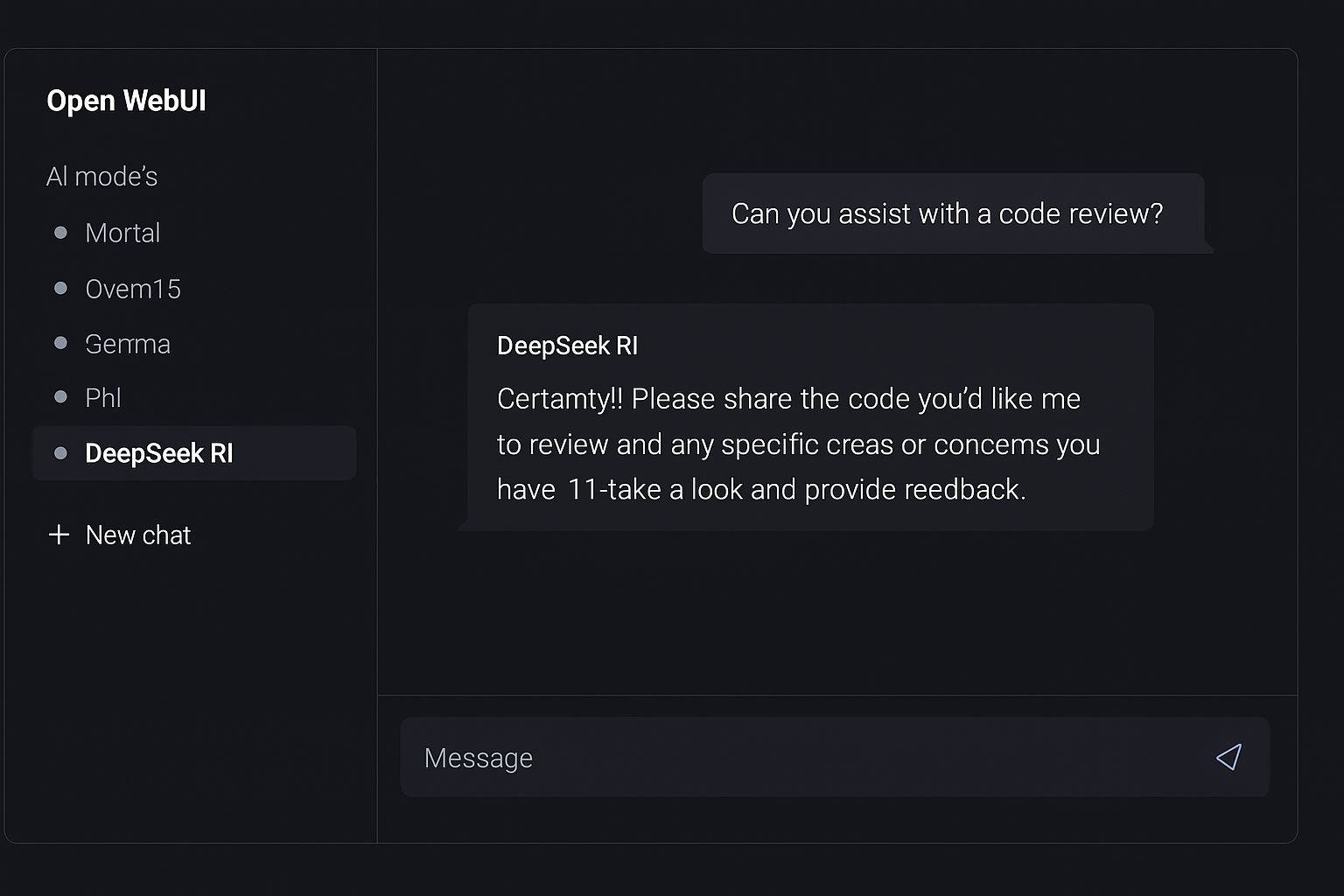

Open WebUI — ローカルAIのChatGPTライクなインターフェース

ブラウザでhttp://localhost:3000を開いてください。アカウントを作成(ローカル — 最初のユーザーが管理者になる)し、DeepSeek R1モデルを選択して、チャットを開始してください。

ステップ5:チームに公開(オプション)

同僚と共有したい場合は、リバースプロキシを設定:

server {

listen 443 ssl;

server_name ai.yourcompany.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}あなたのチームは洗練されたWebインターフェースを持つプライベート、セルフホストAIアシスタントを手に入れました。総セットアップ時間:約10分。

ユースケース:何をいつ選ぶか

ChatGPTを選ぶべき場合:

- 🔵マルチモーダルAIが必要(画像分析、音声、DALL-E)

- 🔵ゼロメンテナンスと即座のアクセスを望む

- 🔵個人ユーザーで中程度の使用(月額約20ドルでOK)

- 🔵回答に統合されたリアルタイムWebブラウジングが必要

- 🔵最新モデルが必要(OpenAIは週次アップデートをリリース)

- 🔵プロトタイプを構築し、すぐに開始したい

セルフホストDeepSeek R1を選ぶべき場合:

- 🟢データプライバシーが妥協不可能(規制業界、プロプライエタリコード)

- 🟢3+のチームを持っている(コストはフラット、ユーザーごとではない)

- 🟢大量を処理する(バッチ分析、自動化パイプライン)

- 🟢オフライン能力が必要(エアギャップ環境、旅行)

- 🟢ドメインデータでモデルをファインチューンしたい

- 🟢製品にAIを組み込んでいる(API依存性なし)

- 🟢予測可能なコストを望む(サプライズ請求書なし)

- 🟢一貫したパフォーマンスが必要(レート制限やダウンタイムなし)

ハイブリッドアプローチ

2026年の多くのチームは両方を実行します:日常のコーディング支援、文書レビュー、バッチ処理にローカルDeepSeek R1 — 時折のマルチモーダルタスクと最先端モデルへのアクセスのためにChatGPT Proサブスクリプションを維持。これにより、クラウドコストを最小化しながら両方の世界のベストを得られます。

大局:なぜAIのセルフホスティングが重要か

セルフホストAIへの移行は、お金を節約することだけではありません。主権に関することです。

クラウドAIプロバイダーに依存する場合、あなたは次のことに従うことになります:

- 価格変更 — OpenAIは以前に価格を上げており、再び上げるでしょう

- ポリシー変更 — サービス利用規約は一夜にして変わる可能性

- 検閲決定 — モデルが議論することと議論しないこと

- 可用性 — 停止が発生し、レート制限が厳しくなる

- 地政学的リスク — 地域によってアクセスが制限される可能性

- モデル更新 — お気に入りのモデルバージョンが廃止される可能性

セルフホストモデルでは、あなたがAIスタックを所有します。実行するモデル、動作方法、見るデータ、いつアップグレードするかを選択します。これは技術的優位性だけではありません — 戦略的優位性です。

結論:2026年のスマートな動き

一年前、AIのセルフホスティングは愛好家の実験でした。今日、それは世界中のスタートアップ、企業、独立開発者によって使用される本番環境対応戦略です。

DeepSeek R1は、ChatGPTと競合し、一部のベンチマークでは上回る推論能力を提供します。Ollamaはデプロイメントを簡単にします。Open WebUIは洗練されたインターフェースを提供します。そしてあなたはすべてのデータバイトをあなたのコントロール下に保ちます。

計算はシンプルです:

- ChatGPT Plusの10人チーム:年額2,400ドル

- セルフホストDeepSeek R1の10人チーム:年額360ドル

- 年間節約:2,040ドル — プラス完全なデータ主権

ChatGPTは依然として優れた製品です。しかし、データをプライベートに保ちながらコストの一部でコア機能をマッチできるとき、スマートな動きは明確です。

セルフホスティング革命は来ているのではありません — それは既にここにあります。問題は:あなたのチームは先頭に立つか、サイドラインから見るかです?

もっとセルフホストAIツールを探索する準備はできましたか? hostly.shでセルフホスト可能なアプリケーションの厳選されたディレクトリを閲覧してください — AIアシスタントから自動化プラットフォームまで、あなた自身のインフラストラクチャで実行するための最高のオープンソースソフトウェアを見つけるお手伝いをします。

AIワークロード用の強力なVPSが必要ですか? 機械学習とAIアプリケーション用に特別に設計された最適化ホスティングプランをチェックしてください。数分で本番環境対応サーバーでDeepSeek R1を開始してください。

この比較が役に立ちましたか?人気のあるSaaSツールのセルフホスト代替案に関する他のガイドをチェックしてください。