Die KI-Landschaft hat sich dramatisch verändert. Im Januar 2025 stürmte DeepSeek R1 auf die Bühne — ein Reasoning-Modell mit offenen Gewichten, das GPT-4-Klassenleistung erreichte und dabei vollständig selbst gehostet werden kann. Es sandte Schockwellen durch die Branche, löschte kurzzeitig fast 1 Billion Dollar von Nvidias Marktkapitalisierung und zwang jedes Tech-Team, sich eine einfache Frage zu stellen: Warum bezahlen wir immer noch für Cloud-KI?

Ein Jahr später ist die Antwort noch klarer. DeepSeek R1 und seine destillierten Varianten laufen wunderbar auf Standardhardware über Ollama. ChatGPT bleibt ein poliertes Cloud-Produkt — aber zu wiederkehrenden Kosten, wobei Ihre Daten über OpenAIs Server fließen.

In diesem umfassenden Vergleich analysieren wir Kosten, Datenschutz, Leistung und Anwendungsfälle, um Ihnen bei der Entscheidung zu helfen, welcher Weg für Ihr Team im Jahr 2026 der richtige ist.

TL;DR — Der schnelle Vergleich

| Merkmal | DeepSeek R1 (Selbst gehostet) | ChatGPT (OpenAI Cloud) |

|---|---|---|

| Hosting | Ihre Hardware / VPS | OpenAI-Server |

| Kostenmodell | Einmalige Hardware + Strom | 20–200$/Monat pro Benutzer (Abo) oder Pay-per-Token API |

| Datenschutz | 100% lokal — nichts verlässt Ihr Netzwerk | Daten werden auf OpenAI-Servern verarbeitet |

| Modellzugang | Offene Gewichte (MIT-Lizenz) | Proprietär, geschlossener Quellcode |

| Offline-Nutzung | ✅ Volle Funktionalität offline | ❌ Erfordert Internet |

| Anpassung | Fine-Tuning, Quantisierung, frei modifizierbar | Beschränkt auf System-Prompts und GPTs |

| Reasoning-Qualität | Vergleichbar mit GPT-4o bei Mathe- und Code-Benchmarks | State-of-the-Art mit GPT-4o / o1 |

| Einrichtung | ~10 Minuten mit Ollama | Registrieren und los |

| Modellgrößen | 1,5B bis 671B Parameter | N/A (nur Cloud) |

| Rate Limits | Keine — nur durch Ihre Hardware begrenzt | Stufenbasierte API-Rate-Limits |

Warum DeepSeek R1 alles verändert hat

Die Open-Weight-Revolution

DeepSeek R1 war nicht nur ein weiteres Open-Source-Modell. Es war der Beweis, dass ein chinesisches KI-Labor Reasoning-Fähigkeiten produzieren konnte, die mit dem Besten von OpenAI mithalten — und dann die Gewichte kostenlos veröffentlichen konnte. Die Modellfamilie reicht von einer winzigen destillierten 1,5B-Version (läuft auf einem Raspberry Pi) bis zum vollen 671B-Parameter Mixture-of-Experts-Koloss.

Wichtige Benchmark-Ergebnisse, die Aufmerksamkeit erregten:

- AIME 2024 (Mathematik): DeepSeek R1 erzielte 79,8%, vergleichbar mit OpenAIs o1-mini

- Codeforces (Competitive Programming): Elo-Rating von 2.029 — ebenbürtig mit Top-Programmierern

- MATH-500: 97,3% Genauigkeit, übertrifft GPT-4o

- GPQA Diamond (Wissenschaft auf Graduiertenniveau): 71,5%, wettbewerbsfähig mit o1-preview

Die Botschaft war unmissverständlich: Sie brauchen keine 200$/Monat API-Rechnung mehr, um auf Frontier-Level-Reasoning zuzugreifen.

Warum es jetzt wichtig ist

Im Jahr 2026 ist das DeepSeek-Ökosystem erheblich gereift:

- Ollama bietet Ein-Befehl-Deployment für alle DeepSeek R1-Varianten

- Quantisierte Modelle (Q4_K_M, Q8) lassen das 70B-Destillat reibungslos auf einem MacBook Pro mit 64GB RAM laufen

- Open WebUI gibt Ihnen eine ChatGPT-ähnliche Oberfläche über Ihrem lokalen Modell

- Community Fine-Tunes existieren für jede Domäne von Recht über Medizin bis Code-Review

Die Infrastruktur ist produktionsreif. Die Frage ist nicht können Sie selbst hosten — sondern warum würden Sie es nicht tun?

Kostenvergleich: Die Zahlen lügen nicht

ChatGPT-Preise 2026

OpenAIs Preisstruktur hat sich weiterentwickelt, aber das Kernmodell bleibt: Sie zahlen pro Benutzer, pro Monat, für immer.

| Plan | Preis | Was Sie bekommen |

|---|---|---|

| Kostenlos | 0$ | Begrenzter GPT-4o-Zugang, ratenbegrenzt |

| Plus | 20$/Monat | Mehr GPT-4o, o1-Zugang, DALL-E, Browsing |

| Pro | 200$/Monat | Unbegrenzter Zugang zu allen Modellen, o1 Pro-Modus |

| Team | 25–30$/Benutzer/Monat | Workspace-Funktionen, Admin-Kontrollen |

| Enterprise | Individuell | SSO, Compliance, dedizierter Support |

API-Preise (Pay-per-Token):

- GPT-4o: ~2,50$/1M Input-Token, ~10$/1M Output-Token

- o1: ~15$/1M Input-Token, ~60$/1M Output-Token

Für ein Team von 10 Entwicklern mit ChatGPT Plus sind das mindestens 2.400$/Jahr. Intensive API-Nutzung kann die Kosten leicht auf 10.000–50.000$/Jahr treiben.

Kosten für selbst gehostetes DeepSeek R1

Die Schönheit des Self-Hostings: Die Kosten sind fest und vorhersehbar.

| Setup | Hardwarekosten | Monatliche Kosten | Leistungsstufe |

|---|---|---|---|

| MacBook Pro M4 Max (128GB) | ~4.000$ (bereits vorhanden?) | ~5$ Strom | Läuft 70B-Destillat komfortabel |

| Desktop mit RTX 4090 (24GB) | ~2.000$ GPU | ~10$ Strom | Läuft 32B-Destillat mit hoher Geschwindigkeit |

| VPS (Hetzner, 8 vCPU, 32GB) | — | ~30$/Monat | Läuft 14B-Destillat für kleines Team |

| Dual RTX 3090 Server | ~3.000$ gesamt | ~20$ Strom | Läuft 70B-Destillat, dient 5–10 Benutzern |

| Cloud GPU (RunPod/Vast.ai) | — | ~50–150$/Monat | Volles 671B-Modell möglich |

Break-Even-Analyse für ein 10-Personen-Team:

- ChatGPT Plus für 10 Benutzer: 200$/Monat = 2.400$/Jahr

- Selbst gehostetes DeepSeek R1 auf einem Hetzner VPS: 30$/Monat = 360$/Jahr

- Ersparnis: 2.040$/Jahr (85%)

Und das ist das konservative Szenario. Wenn Ihr Team die API intensiv für Codegenerierung, Dokumentenanalyse oder automatisierte Workflows nutzt, vervielfachen sich die Einsparungen dramatisch. Beim Self-Hosting kosten 10.000 Anfragen genauso viel wie 10 Anfragen: null Grenzkosten.

Datenschutz: Der Elefant im Serverraum

Hier liefert Self-Hosting seinen überzeugendsten Vorteil — und es ist nicht einmal annähernd vergleichbar.

Was mit ChatGPT passiert

Wenn Sie einen Prompt an ChatGPT senden:

- Ihre Daten reisen über das Internet zu OpenAIs Servern (gehostet auf Microsoft Azure)

- Sie werden verarbeitet, möglicherweise protokolliert und gemäß OpenAIs Datenaufbewahrungsrichtlinien gespeichert

- OpenAIs Datenschutzrichtlinie erlaubt die Nutzung Ihrer Daten zur Modellverbesserung (es sei denn, Sie widersprechen über API-Einstellungen oder Enterprise-Plan)

- Sie unterliegen der US-Gerichtsbarkeit, unabhängig von Ihrem Standort

Für Privatpersonen beim gelegentlichen Chatten ist das in Ordnung. Für Unternehmen, die mit proprietärem Code, Rechtsdokumenten, Patientendaten, Finanzunterlagen oder Geschäftsgeheimnissen arbeiten, ist es inakzeptabel.

Was mit selbst gehostetem DeepSeek R1 passiert

Ihre Daten verlassen niemals Ihre Maschine. Punkt.

- Prompts werden lokal auf Ihrer CPU/GPU verarbeitet

- Keine Telemetrie, keine Protokollierung an externe Server

- Volle DSGVO/HIPAA-Konformität standardmäßig — Daten bleiben in Ihrer Jurisdiktion

- Air-Gapped-Deployment für maximale Sicherheit möglich

- Sie kontrollieren Aufbewahrung, Verschlüsselung und Zugriffsrichtlinien

Für regulierte Branchen (Gesundheit, Finanzen, Recht, Regierung) ist das kein Nice-to-have. Es ist eine Anforderung.

Praxisnahe Datenschutzszenarien

| Szenario | ChatGPT | DeepSeek R1 selbst gehostet |

|---|---|---|

| Überprüfung von proprietärem Quellcode | ⚠️ Code an OpenAI-Server gesendet | ✅ Bleibt auf Ihrer Maschine |

| Analyse von Patientenakten | ❌ HIPAA-Compliance-Risiko | ✅ Vollständig lokal konform |

| Zusammenfassung vertraulicher Rechtsschriften | ⚠️ Potenzielle Datenexposition | ✅ Air-Gappable |

| Verarbeitung von Kunden-PII | ⚠️ Drittanbieter-Datenverarbeiter | ✅ Sie sind der alleinige Verarbeiter |

| Arbeit an klassifizierten Projekten | ❌ Nicht möglich | ✅ Offline-fähig |

Leistung: Wie vergleichen sie sich wirklich?

Seien wir ehrlich darüber, was Sie mit jeder Option erhalten.

Wo ChatGPT (GPT-4o / o1) gewinnt

- ✅Multimodale Fähigkeiten: Bildverständnis, DALL-E-Generierung, Sprachmodus

- ✅Browsing und Plugins: Echtzeit-Webzugang, Code-Ausführung

- ✅Größte Kontextfenster: Bis zu 128K Token mit GPT-4o

- ✅Modernste Reasoning: o1 und o1-pro für komplexe mehrstufige Probleme

- ✅Null Einrichtung: Funktioniert sofort in jedem Browser

Wo DeepSeek R1 gewinnt

- ✅Keine Rate-Limits: Generieren Sie so viel Text, wie Ihre Hardware erlaubt

- ✅Konsistente Latenz: Keine Warteschlange, keine Meldungen über hohe Nachfrage

- ✅Anpassung: Fine-Tuning auf Ihren Domänendaten für überlegene spezialisierte Leistung

- ✅Stapelverarbeitung: Verarbeiten Sie tausende Dokumente über Nacht ohne API-Kosten

- ✅Reproduzierbarkeit: Gleiches Modell, gleiche Gewichte, deterministische Ausgaben

Benchmark-Vergleich (veröffentlichte Ergebnisse 2025)

| Benchmark | DeepSeek R1 (671B) | GPT-4o | o1-mini |

|---|---|---|---|

| MATH-500 | 97,3% | 74,6% | 90,0% |

| AIME 2024 | 79,8% | 9,3% | 63,6% |

| Codeforces Elo | 2.029 | 759 | 1.820 |

| GPQA Diamond | 71,5% | 49,9% | 60,0% |

| MMLU | 90,8% | 88,7% | 85,2% |

| SWE-bench Verified | 49,2% | 38,4% | 41,6% |

Wichtiger Hinweis: Dies sind Benchmarks für das volle 671B-Modell. Wenn Sie eine destillierte 7B- oder 14B-Variante auf bescheidener Hardware betreiben, erwarten Sie niedrigere Werte. Das 70B-Destillat behält den Großteil der Reasoning-Fähigkeit und ist der Sweet Spot für Self-Hosting.

Schnellstart-Anleitung: DeepSeek R1 + Ollama + Open WebUI

So gelangen Sie in weniger als 10 Minuten von Null zu Ihrem eigenen KI-Assistenten.

Schritt 1: Ollama installieren

# macOS / Linux

curl -fsSL https://ollama.com/install.sh | sh

# Oder auf macOS über Homebrew

brew install ollamaSchritt 2: Ein DeepSeek R1-Modell herunterladen

# Leichtgewicht (4GB RAM Minimum) — gut zum Testen

ollama pull deepseek-r1:8b

# Mittelklasse (16GB RAM) — solider Alltagsbegleiter

ollama pull deepseek-r1:14b

# Power-User (32-64GB RAM) — nahezu volle Reasoning-Fähigkeit

ollama pull deepseek-r1:32b

# Beast-Modus (64GB+ RAM oder Multi-GPU) — maximale Qualität

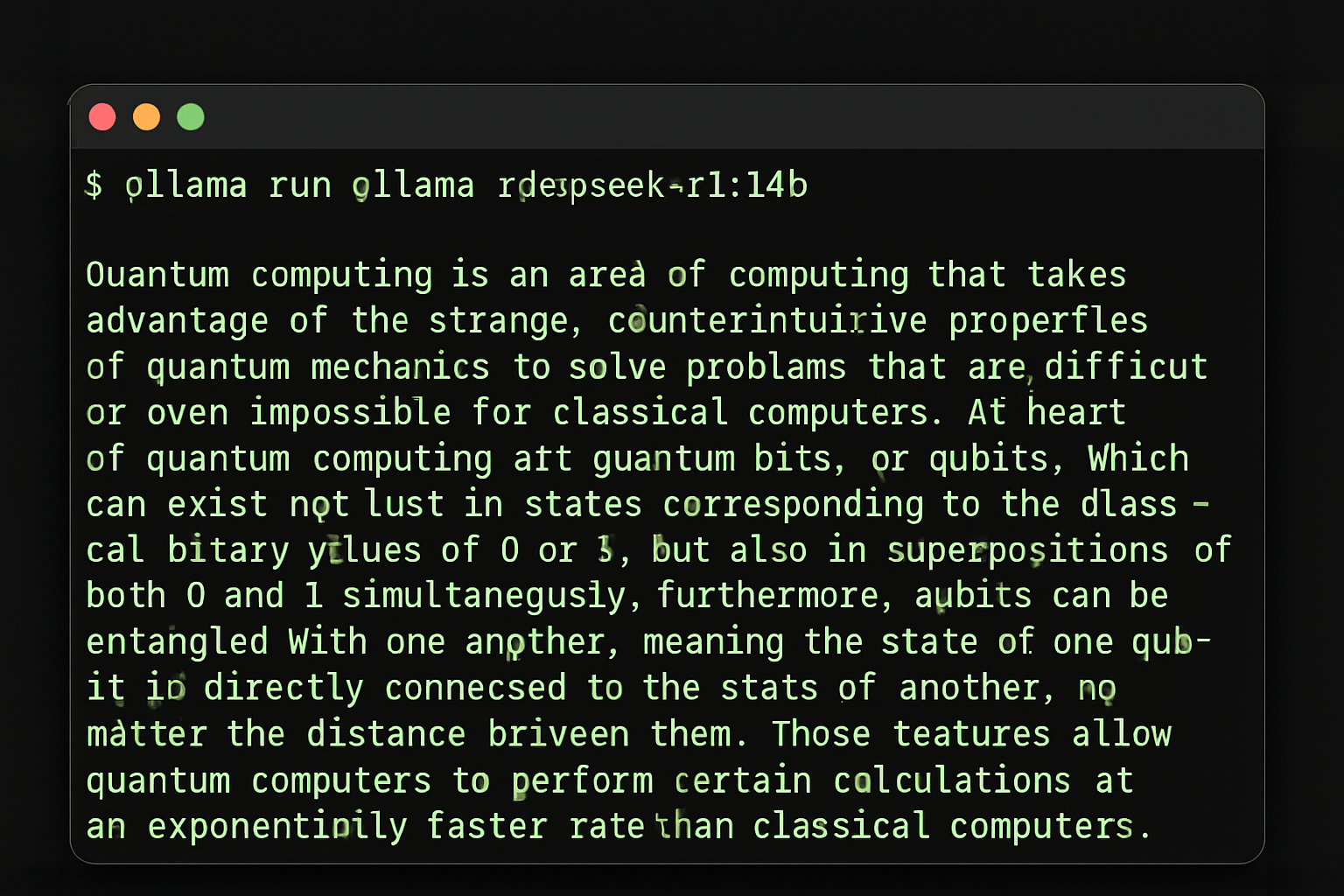

ollama pull deepseek-r1:70bSchritt 3: Im Terminal testen

ollama run deepseek-r1:14b

Ollama mit DeepSeek R1 — ein Befehl zum Starten

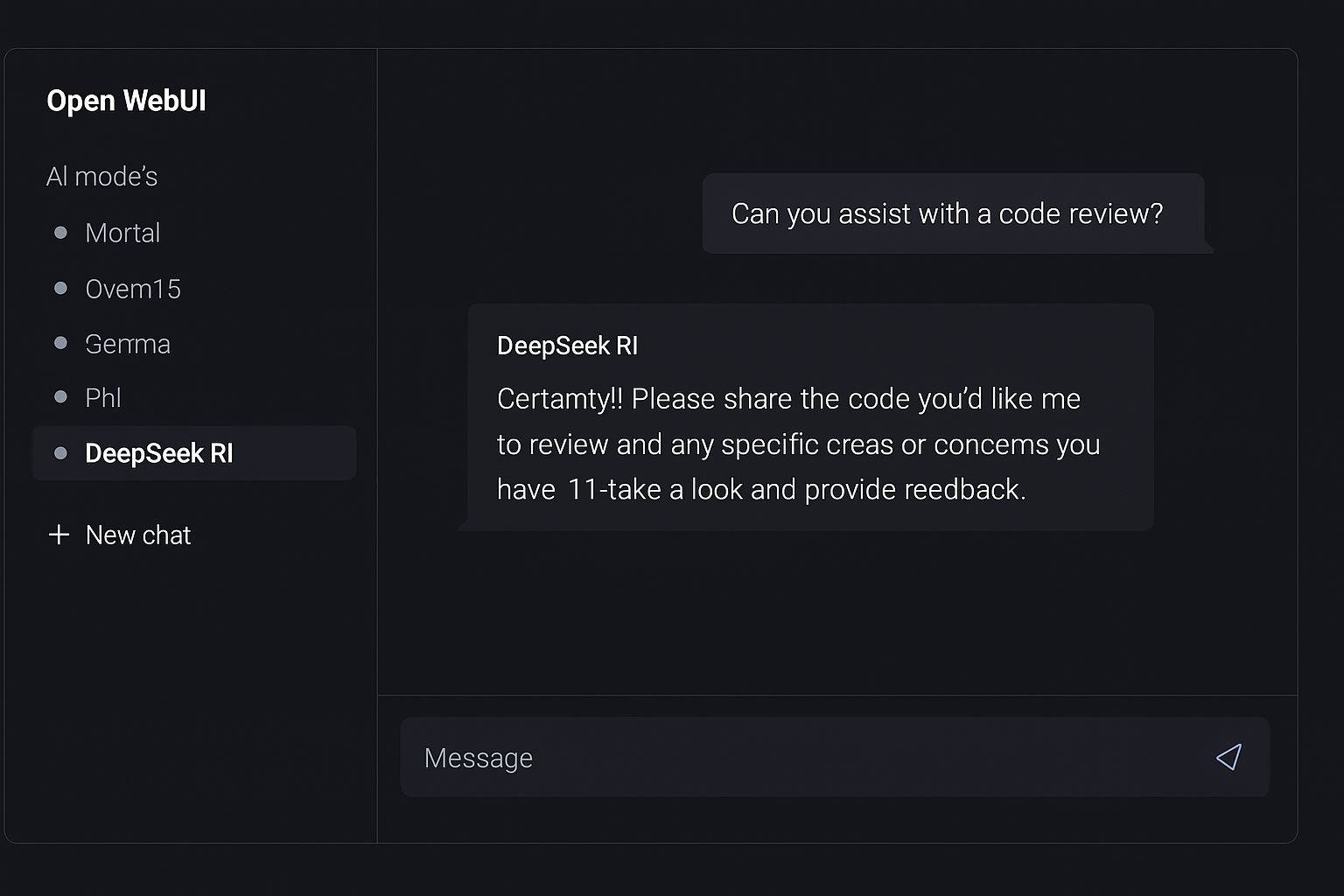

Schritt 4: Open WebUI für ChatGPT-ähnliche Oberfläche hinzufügen

# Mit Docker (empfohlen)

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 \

--restart always \

ghcr.io/open-webui/open-webui:main

Open WebUI — eine ChatGPT-ähnliche Oberfläche für Ihre lokale KI

Öffnen Sie jetzt http://localhost:3000 in Ihrem Browser. Erstellen Sie ein Konto (es ist lokal — der erste Benutzer wird Admin), wählen Sie Ihr DeepSeek R1-Modell und beginnen Sie zu chatten.

Schritt 5: Für Ihr Team freigeben (optional)

server {

listen 443 ssl;

server_name ai.ihrfirma.de;

ssl_certificate /pfad/zu/cert.pem;

ssl_certificate_key /pfad/zu/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}Ihr Team hat jetzt einen privaten, selbst gehosteten KI-Assistenten mit einer polierten Web-Oberfläche. Gesamte Einrichtungszeit: ~10 Minuten.

Anwendungsfälle: Wann was wählen

Wählen Sie ChatGPT wenn:

- 🔵Sie multimodale KI benötigen (Bildanalyse, Sprache, DALL-E)

- 🔵Sie null Wartung wollen und sofortigen Zugang

- 🔵Sie Einzelnutzer sind mit moderater Nutzung (~20$/Monat ist OK)

- 🔵Sie Echtzeit-Webbrowsing benötigen in Antworten integriert

- 🔵Sie das neueste Modell benötigen (OpenAI liefert wöchentlich Updates)

Wählen Sie selbst gehostetes DeepSeek R1 wenn:

- 🟢Datenschutz nicht verhandelbar ist (regulierte Branchen, proprietärer Code)

- 🟢Sie ein Team von 3+ haben (Kosten skalieren flach, nicht pro Benutzer)

- 🟢Sie hohe Volumina verarbeiten (Stapelanalyse, automatisierte Pipelines)

- 🟢Sie Offline-Fähigkeit benötigen (Air-Gapped-Umgebungen, Reisen)

- 🟢Sie das Modell fine-tunen wollen auf Ihren Domänendaten

- 🟢Sie KI in Ihr Produkt einbauen (keine API-Abhängigkeit)

- 🟢Sie vorhersehbare Kosten wollen (keine Überraschungsrechnungen)

Der hybride Ansatz

Viele Teams im Jahr 2026 betreiben beides: DeepSeek R1 lokal für die tägliche Codierungshilfe, Dokumentenprüfung und Stapelverarbeitung — während sie ein ChatGPT Pro-Abo für gelegentliche multimodale Aufgaben und Zugang zu den neuesten Modellen behalten. Dies gibt Ihnen das Beste aus beiden Welten bei minimalen Cloud-Kosten.

Das große Bild: Warum Self-Hosting von KI wichtig ist

Der Trend zum selbst gehosteten KI geht nicht nur ums Geldsparen. Es geht um Souveränität.

Wenn Sie von einem Cloud-KI-Anbieter abhängen, sind Sie ausgesetzt:

- Preisänderungen — OpenAI hat Preise schon erhöht und wird es wieder tun

- Richtlinienänderungen — Nutzungsbedingungen können sich über Nacht ändern

- Zensurentscheidungen — Was das Modell diskutieren wird und was nicht

- Verfügbarkeit — Ausfälle passieren, Rate-Limits werden verschärft

- Geopolitisches Risiko — Zugang kann nach Region eingeschränkt werden

Mit selbst gehosteten Modellen besitzen Sie Ihren KI-Stack. Sie wählen, welches Modell Sie betreiben, wie es sich verhält, welche Daten es sieht und wann Sie aktualisieren. Das ist nicht nur ein technischer Vorteil — es ist ein strategischer.

Fazit: Der kluge Schachzug im Jahr 2026

Vor einem Jahr war Self-Hosting von KI ein Experiment für Bastler. Heute ist es eine produktionsreife Strategie, die von Startups, Unternehmen und unabhängigen Entwicklern weltweit genutzt wird.

DeepSeek R1 bietet Reasoning-Fähigkeiten, die mit ChatGPT konkurrieren — und in einigen Benchmarks übertreffen. Ollama macht das Deployment trivial. Open WebUI bietet eine polierte Oberfläche. Und Sie behalten jedes Byte Ihrer Daten unter Ihrer Kontrolle.

Die Rechnung ist einfach:

- 10-Personen-Team mit ChatGPT Plus: 2.400$/Jahr

- 10-Personen-Team mit selbst gehostetem DeepSeek R1: 360$/Jahr

- Jährliche Ersparnis: 2.040$ — und vollständige Datensouveränität

ChatGPT bleibt ein hervorragendes Produkt. Aber wenn Sie seine Kernfähigkeiten zu einem Bruchteil der Kosten erreichen und gleichzeitig Ihre Daten privat halten können, ist der kluge Schachzug klar.

Bereit, mehr selbst gehostete KI-Tools zu entdecken? Durchsuchen Sie unser kuratiertes Verzeichnis selbst hostbarer Anwendungen auf hostly.sh — von KI-Assistenten bis zu Automatisierungsplattformen helfen wir Ihnen, die beste Open-Source-Software für Ihre eigene Infrastruktur zu finden.

Fanden Sie diesen Vergleich nützlich? Schauen Sie sich unsere anderen Anleitungen zu selbst gehosteten Alternativen beliebter SaaS-Tools an.